Seo quiz, un emploi à la clef

RESONEO est un cabinet de conseil en stratégie marketing pour Internet.

Pour accompagner le développement de nos clients, nous recherchons régulièrement des consultants SEO seniors:

- capables de concevoir une stratégie de référencement globale (analyses techniques, linguistiques et netlinking)

- possédant la double approche marketing et technique du référencement naturel

- dotés de compétences fortes en gestion de projets

- familiers des outils de web analytics

- à l’aise dans la relation client et la compréhension de leurs problématiques business

Qui sait ? Le quiz aborde des tas d'aspects du marketing web. Vous découvrirez peut être que vous en savez plus que vous ne pensez.

Et n'hésitez pas à relayer ce quiz à vos relations, ne serait-ce que par goût du challenge et pour savoir s'ils en savent plus que vous ! Les étoiles du Stars Spangled Banner trancheront !

Publié par Admin 01:28 0 commentaires

Probleme liés aux annuaires DMOZ et YAHOO

Certains site on souvent n’importe quoi dans le ”TITLE” et la balise META “description” de leurs pages. DMOZ est un important répertoire de sites web et Google et MSN/Live se sont donc dit que les titres et descriptions publiés par DMOZ pouvaient être considérés comme plus fiables que l’information trouvée directement sur les sites eux-mêmes, car validés par les membres de l'annuaire.

Google et MSN/Live ont alors créé:

name="”ROBOTS”" content="”NOODP”"

qui permet à un webmaster de demander explicitement aux moteurs de recherche de ne pas utiliser le titre et la description de DMOZ.

Yahoo n’utilise pas DMOZ, mais il utilise parfois les titres et descriptions de son propre annuaire (Yahoo Directory) . Apparemment les mêmes problèmes se posent avec l’annuaire Yahoo qu’avec DMOZ. Et voici donc la solution originale proposée par Yahoo:

name="”ROBOTS”" content="”NOYDIR”"

qui permet à un webmaster de demander explicitement aux moteurs de recherche de ne pas utiliser le titre et la description de l’annuair de yahoo.

Publié par Admin 07:08 0 commentaires

Kabonfootprint, le nouveau concours SEO

Un footprint c'est quoi?

Wikipedia nous dis tout:

Footprints can be followed when tracking during a hunt or can provide evidence of activities.

Some footprints remain unexplained, with several famous stories from mythology and legend. Others have provided evidence of prehistoric life and behaviours.

Voila une petite explication de l'origine du nom du concours Kabonfootprint.

Publié par Admin 06:28 0 commentaires

Test SEO Master

Testez vos connaissances en SEO et positionnez un lien vers votre site. Plus vous serez bon, plus votre lien sera bien placé ;) http://www.trackbusters.fr/seo-masters/

http://www.trackbusters.fr/seo-masters/

Publié par Admin 05:50 0 commentaires

Guide lines Google, Yahoo et Live Search

Google Guidelines

Yahoo Guidelines

MSN Guidelines

Publié par Admin 08:32 0 commentaires

Libellés : google, guidelines, msn, yahoo

Cuil, nouveau moteur de recherche

Monté à l’aide d’une coentreprise (joint venture) de 33 millions de dollars, ce moteur impressionne déjà quant à la base d’indexation. Elle serait en effet trois fois plus importante que celle de l’indétrônable Google : plus 120 milliards de pages, contre 40 milliards, annonce le site. Alors que le lancement de Cuil se précisait, Google annonçait vite fait bien fait sur son blog qu’il avait repéré pas moins de 1 000 000 000 000 d'URL (1 billion, ou 1000 milliards), pour en indexer en fait beaucoup moins, en tenant compte des doublons, des pages vides, etc.

Mais au-delà de ces chiffres testostéronés, d’autres différences sont plus notables : les résultats sont ainsi contextualisés en différentes catégories, afin d’aider l’utilisateur dans la jungle des réponses. Ce classement tient à ce que l’affichage des données se base davantage sur les contenus, le contexte de chaque page plutôt que sur la popularité de liens pointant vers telle ou telle URL, ou de clics dans les résultats. Cette approche mettrait ainsi la qualité au devant de la quantité.

Ainsi, une requête sur Bill Gates classera les données selon la Fondation Bill et Melinda Gates, le business des logiciels, les employés Microsoft, les milliardaires américains, etc. Cette manière d’afficher les données explique comment Cuil sait propager l’information à la manière d’un magazine en ligne.

Les préférences sont réduites au strict minimum : un filtrage des contenus pour adultes (activé par défaut) et les suggestions au fil de la saisie (autocomplétion). Au niveau des logs, on retrouve ce détachement face à la toute-puissance du clic. Cuil ne garde aucune trace des logs liés aux activités de recherche des utilisateurs, du moins c’est ce qu’annoncent les pages.

Les test menés jusqu'a présent ne sont pas tres concluants, je reste donc en attente d'améliorations...

Publié par Admin 05:50 0 commentaires

Libellés : moteur de recherche

Knol, le wikipedia version Google

Wikipedia peu trembler. Évidemment, tout le monde pense que Knol souhaite concurrencer Wikipedia sur son propre terrain : une encyclopédie dont tout le contenu est fourni gracieusement par des utilisateurs. Pour Google, Knol corrige un très grave défaut de Wikipedia : l'absence de publicités et l'integration importante d'un aspect collaboratif : chaque membre peu discuter sur un article.

http://knol.google.com/

Un probleme SEO?

Tout est sur webrankinfo.com!

Publié par Admin 01:55 0 commentaires

Libellés : annonce

Gmail Lab

Google n’est jamais avare en expérimentations diverses, et là c’est Gmail qui est mis à l’honneur dernièrement. Ainsi, si vous modifiez la langue par défaut de votre boite e-mail pour la passer en anglais, vous aurez droit à un nouvel onglet disponible dans vos “settings”.

Vous trouvez dans cette section de nombreuses nouveautés, pas forcément toujours très abouties au stade d’essai mais que Google souhaite pouvoir tester auprès du plus grand nombre. Par défaut elles sont toutes inactives, à vous de décider lesquelles vous voulez adopter.

14 fonctionnalités au choix.

La fonction “Quick Links” permet de créer des favoris vers vos messages favoris, pour accéder plus facilement, et “Superstars” d’ajouter d’autres étoiles de différentes couleurs pour mieux repérer certaines discutions. Suivent “Pictures in chat” pour afficher la photo de vos contacts lorsque vous tchattez avec eux, “Fixed width font” qui égalise la taille de la police, “Custom keyboard shortcuts” qui personnalise l’ensemble des raccourcis clavier, “Mouse gestures” qui définit des mouvements de souris pour effectuer certaines actions, “Hide unread counts” masque le nombre de mails encore non lus, “Random signature” pioche au hasard des citations pour alimenter vos signature et “Custom date formats” modifie l’affichage de l’heure.

Signalons enfin “Old Snakey”, une option amusante qui lance le fameux jeu du serpent, simplement en appuyant sur la touch “&” de votre clavier ! Vous ne trouverez donc rien de révolutionnaire, mais quelques aménagements qui raviront les utilisateurs de Gmail les plus acharnés.

Publié par Admin 02:33 0 commentaires

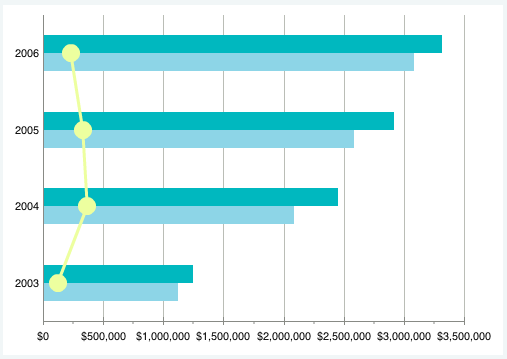

Charts Google et Yahoo

L'outil de Yahoo s'adresse plus a des développeurs experts, et celui de google est plus simple a mettre en place.

Voici une des possibilités de l'outil Yahoo:

Et ce que ca donne du coté de Google.

Pour ma part je préfere l'outil Google, plus facile à mettre en place puisqu'il n'y qu'a construire une url, alors que Yahoo necessite le creation de code dans le head, et des scripts javascript à tous va!

Pour ma part je préfere l'outil Google, plus facile à mettre en place puisqu'il n'y qu'a construire une url, alors que Yahoo necessite le creation de code dans le head, et des scripts javascript à tous va!Publié par Admin 07:01 0 commentaires

Google trend websites

Google viens de proposer une nouveauté pour son outil Trend. On peut maintenant visualiser les nombre de visiteurs unique pour les sites les plus visités.

En voir plus...

Publié par Admin 06:58 0 commentaires

Nouvelle version de Google Trend

Voici la news Google traduite par l'outil Google (ça vaut ce que ça vaut):

La dernière version de Google Trends est maintenant en ligne! Si vous avez utilisé dans le passé, vous savez que Google Trends peut être utilisé pour voir comment populaire certains termes de recherche sont dans les régions, les villes et les langues. Avec notre dernière mise à jour, vous pouvez maintenant voir les numéros sur le graphique pour télécharger une feuille de calcul. (Note: Ces deux fonctions sont disponibles après que vous avez connecté à votre compte Google.)

Let's promenade à travers un exemple de comment ces astucieux de nouvelles fonctionnalités en ligne de compte. Avec les mois chauds d'été approchent rapidement dans de nombreuses régions du monde, beaucoup d'entre nous se tournent vers le traiter de gel de la crème glacée pour se rafraîchir. Mais avez-vous déjà demandé de la variante de recherche pour les personnes plus fréquemment: vanille ou chocolat?

Tout d'abord, nous allons jeter un coup d'oeil à la recherche de Vanilla Ice crème et glace au chocolat séparément. Voici ce qui ressemble à la vanille sur son propre:

Vous verrez un numéro en haut du graphique ainsi que sur l'axe des ordonnées du graphique lui-même. Ces chiffres ne se réfèrent pas à des recherches exactes volume chiffres. Au lieu de cela, au même titre que la carte peut-être une "échelle" d'une certaine taille, échelles Google Trends le premier terme que vous avez entré de manière à ce que son volume de recherche moyen est de 1,00 fois la période choisie. Ainsi dans l'exemple ci-dessus, 1,00 est la moyenne des volumes de recherche de Vanilla Ice crème de 2004 à aujourd'hui. Nous pourrons alors voir un pic à la mi-2006 qui traverse la ligne de 3,00, ce qui indique que le trafic de recherche est d'environ 3 fois la moyenne pour toutes les années. En savoir plus sur la façon dont nous échelle des données.

Voici ce que le chocolat ressemble à celui de sa propre:

Regardons comment se compare la vanille au chocolat. Gardez à l'esprit que lorsque vous comparez plusieurs termes, ils vont tous être élargis par rapport au premier terme que vous avez entré.

Comme les chiffres en haut du graphique indiquent, Vanilla Ice crème a environ 30 pour cent de moins que le trafic de recherche glace au chocolat (et il n'est pas étonnant que les deux saveurs sont plus populaires pendant les mois d'été!) Vous pouvez également voir que les données été classés par la vanille, parce que c'était la première recherche, nous sommes entrés. Toutefois, vous pouvez utiliser le menu déroulant sous le graphique pour modifier le classement au lieu de chocolat.

Google Trends n'est pas seulement un outil de plaisir, il offre également quelques applications pratiques ainsi. Supposons que vous êtes propriétaire d'un magasin de crème glacée et ne savent pas qui les saveurs de servir, ou supposons que vous êtes responsable pour le stockage des supermarchés à travers le pays, les tendances peuvent vous aider à explorer la popularité et la saisonnalité de vos produits. Pour effectuer vos propres, des analyses plus détaillées, vous pouvez facilement exporter les tendances des données sur un fichier. Csv (un format commun d'importer / exporter des données), qui peut être ouvert dans la plupart des tableurs. Lorsque vous utilisez la fonction d'exportation, vous aurez également le choix d'utiliser soit l'échelle relative (ce que nous avons démontré ici) ou fixe l'échelle (échelle à une plage de temps).

Nous espérons que vous apprécierez cette nouvelle saveur de Google Trends. Et bien sûr, nous voulons savoir qui saveur de crème glacée-vous aimez le plus?

Publié par Admin 04:19 0 commentaires

SEO Mioche tool

SEO Mioche tool est un outil en php bien sympa qui permet de suivre la position de certains sites sur une liste de mots clefs dans les pages des resultat google.

Publié par Admin 07:15 0 commentaires

67 Moteurs de recherche

Moteur de recherche Audio, MP3 et Vidéos :

- Songza est un moteur de recherche de MP3

- Cleepr moteur de recherche de clips vidéo disponibles sur le Web.

- Lumerias est un nouveau moteur de recherche de vidéos qui effectue ses recherches dans près de 4 millions de fichiers.

- Mp3gle est un moteur de recherche de MP3

- Seeqpod est un moteur de recherche audio et vidéo.

- Tonzr : moteur de recherche de sonnerie de téléphones. A lire aussi ici

- Skreemr est un moteur de recherche de MP3

- Flooby est un métamoteur de recherche surtout spécialisé dans les articles de presse, qui s’ouvre petit à petit aux blogs et documents vidéo.

- Beemp3 est un moteur de recherche de MP3

- Fisssh est un métamoteur qui explore de nombreux domaines : web, actualité, blogs, vidéos, podcasts.

Moteur de recherche Images et Photos :

- Tineye Tineye se donne pour but de retrouver des images copiées sur le Web par un système de reconnaissance de forme

- CreativSpace est un moteur de recherche d’image s’appuyant sur l’interface CoverFlow.

- Xcavator est un moteur d’images par similarité de couleurs ou de forme.

- Picitup : Moteur de recherche d’images. A lire aussi ici

Moteur de recherche Thématiques :

- Ecocho : Moteur de recherche Ecolo. A lire aussi ici

- Twingly est un moteur spécialisé sur le contenu des blogs.

- Speo est un moteur de recherche lancé par Price Minister et entièrement dédié au monde de l’automobile.

- Bati-Search est un moteur de recherche dédié au monde du bâtiment.

- SearchMedica est un moteur spécialisé pour les médecins et le monde de la santé.

- Randonnee est le moteur de recherche de la rando

- Allo Garage est basé sur Google Maps et permet, comme son nom l’indique, de trouver un garage automobile en France.

- Viaduc est un annuaire d’entreprises de type Pages Jaunes.

- Collections : métamoteur de recherche interrogeant quatorze bases de données culturelles : Joconde, Palissy, base Atlas du Louvre ou la base photos des musées nationaux.

- Justbooks est un métamoteur de recherche sur les livres. Il interroge de nombreux sites dont Amazon, la Fnac.

- Pizza.net : le moteur de recherche des Pizzas

- QueryCat est un moteur de recherche qui explore les FAQs

- Newspond est un aggrégateur d’actualités dans trois domaines : technologie, jeux et sciences.

- UFO Crawler est un outil de recherche spécialisé et dédié au monde des OVNIs et autres soucoupes volantes.

- Anooz est un moteur de recherche de petites annonces.

- Twing est un moteur de recherche spécialisé dans les forums de discussion.

- GeoRecherche permet de trouver des entreprises de manière géographique. Permet également de demander des devis. Basé sur Google Maps.

- Gameskoot est un moteur de recherche dédié aux jeux vidéos et a son actualité. A lire aussi ici

- Baby Namer est en effet un moteur de recherche ou plutôt de suggestion de nom pour votre futur enfant. Le site est bien fait et fonctionne parfaitement. A lire aussi ici

- Reci-p est un service qui vous permet simplement de rechercher, de découvrir et de partager des recettes de cuisine. A lire aussi ici

- Volti est un moteur spécialisé dans le domaine de l’électricité, avec plus de 200 fournisseurs et près d’un million de documents référencés.

- Jetcost est un métamoteur de recherche voyages et tourisme en ligne (billets d’avions, hôtels, séjours, locations de voiture, etc.).

- WasaLive est un moteur dédié aux recherches touchant à l’actualité au sens large du terme. Il recherche sur les blogs, site de news et forums.

Moteur de recherche Web Communautaire :

- Stumpmedia fait également partie de ces moteurs de recherche sociaux, de plus en plus nombreux sur le Web.

- What’s yo Name tente de rechercher des informations sur les personnes en explorant le Web, les blogs, les réseaux sociaux, etc.

- MySidekick est un moteur de recherche web communautaire basé sur le contenu des pages et les tags qui y sont associées.

- IRazoo est un métamoteur qui permet d’ajouter et de partager des commentaires sur les sites proposés dans les résultats.

- Puzzr est un moteur de recherche dans l’actualité très simple, qui fonctionne sur la base de carrés colorés, chaque thématique ayant une couleur différente.

- Nsyght est un moteur de recherche humain qui met en commun les favoris et infos glanés par la communauté.

- Swotti est un moteur de recherche d’opinions. Il tente de compiler en un seul lien tout ce qui se dit au sujet d’un produit sur le Web.

- Taggylicio.us est en fait un moteur de recherche par Tag ou mot clés. A lire aussi ici

- Ziki est un moteur de recherche de personnes et de société sur Internet.

- Cognivi est un moteur de recherche à l’interface étonnante, basé sur un système communautaire pour positionner ses résultats.

- Jyve est un outil qui permet de mettre en relation des internautes qui se posent des questions et des experts qui peuvent y répondre.

- TagBulb est un moteur de recherche proposant des requêtes sur la base de “tags” dans de nombreux formats (Web, images, vidéos, etc.)

Moteur de recherche Divers :

- Cluuz est un moteur de recherche qui présente ses résultats sous forme de graphes, clusters…etc

- Sbrows propose une interface étonnante, permettant d’aller d’un résultat à l’autre, affiché sous la forme d’une grande vignette, d’un clic de souris.

- Wikio un moteur de recherche de news et d’actualité

- HowDoYa tente de répondre à la question “comment faire pour…”

- Kosmix tente de répartir en catégories les pages web qu’il indexe.

- Boom! Vous aiguille automatiquement sur tel ou tel moteur par l’analyse de votre requête.

- No Food Here est un moteur de recherche basé sur l’API de Yahoo! qui permet de saisir plusieurs mots clés dans des onglets présents en haut de page.

- Webchercheurs est un outil de questions/réponses basé sur des experts, à la manière d’un “Google Answers”.

- Sbrows utilise le moteur de recherche Google pour vous apporter les résultats les plus précis. La différence entre Sbrows et tous les autres moteurs de recherche est l’interface du moteur de recherche et la possibilité de faire une recherche par catégories. A lire aussi ici

- Qwika moteur de recherche de wikis. A lire aussi ici

- All Search Box est Moteur de recherche tout en un, je m’explique : il vous permet de faire des recherches sur tout les moteurs de recherche en ne quittant pas la page d’origine. A lire aussi ici

- ReportLinker est un outil qui effectue des requêtes parmi plus de 1,2 millions d’études de marché en anglais, disponibles gratutement sur le Web.

- Vite Logé, un moteur sur l’immobilier… Si vous ne trouvez pas le logement dans vos rêves avec la foule d’outils de recherche dans ce domaine, c’est que vous êtes vraiment très exigeant

- OMyDir ressemble au principe de l’Open Directory sur une base d’annuaire, mais orienté recherches par mots clés, avec un classement réévalué en temps réel.

Moteur de recherche Emploi :

- Moovement est un moteur spécialisé dans le domaine de l’emploi regroupant plus de 25 000 offres issues de plus de 500 sites web.

- WanaJob a la même vocation autour des offres d’emploi provenant de sites spécialisés du domaine, de magazine et journaux et de sites d’entreprises .

- Rue des Professionnels s’annonce comme “destiné aux Professionnels et Particuliers souhaitant contacter des prestataires de services de qualité.

Moteur de recherche de Téléchargement :

- Torrent’em : Moteur de recherche fichier sur Torrent. A lire aussi ici

- Sharech : Rechercher des fichiers sur des serveurs de téléchargements. A lire aussi ici

- FilesTube : Moteur de recherche pour sites de partage de fichiers. A lire aussi ici

Publié par Admin 01:06 0 commentaires

Libellés : moteur de recherche

Imaginer Google autrement

Il y a quelques mois, Anne-Marie Kermarrec, directrice de recherche en informatique de 37 ans, cherche, pour son enfant, une baby-sitter anglophone, en échange de son hébergement. « Si j'avais pu rassembler dans un gymnase la communauté rennaise des étudiantes anglophones et leur faire ma proposition avec un mégaphone, c'est évident que j'aurais trouvé quelqu'un. »

Faute de gymnase, l'informaticienne pense à Internet. « Les moteurs de recherche comme Google sont très efficaces. Notamment pour chercher quelque chose dans un document. Mais, parfois, les informations y sont vieilles. La rareté et l'individu n'y sont pas favorisés. »Trouver des Anglaises qui n'ont pas encore exprimé sur le Net leur souhait de faire du baby-sitting : Google ne sait pas faire. Les communautés d'internautes qui se retrouvent par affinités existent pourtant, comme Facebook et autres Myspace. Mais l'information y est, finalement, assez statique.

« Ma requête se propage... »

L'idée d'Anne-Marie Kermarrec est donc d'inventer un système où l'individu est au coeur. Quelque chose qui serait à mi-chemin entre les moteurs de recherche classiques et les sites communautaires. « Un endroit où je peux poster une requête. Elle se propage comme une épidémie pour trouver la bonne communauté. Je reçois des réponses. Si elles ne correspondent pas à ma demande, je le dis et ça s'arrête. »

Si elles correspondent, ça signifie qu'il y a un besoin. Alors, à partir de la première annonce, se crée un réseau passant d'ordinateurs à ordinateurs (peer-to-peer) où peuvent se greffer d'autres demandes...

L'idée est prometteuse. Sur 10 000 candidatures européennes, Anne-Marie Kermarrec fait partie des 3 % de lauréats choisis par le Conseil européen de la recherche, toutes disciplines confondues. Le résultat est à la hauteur. La chercheuse obtiendra autour de plus d'un million d'euros pour faire vivre une petite équipe spécifique à ce projet Gossple au sein de son groupe de recherche.

Maintenant, il reste cinq ans pour aboutir. La recherche aura fait un grand pas. Mais il sera trop tard pour trouver une baby-sitter.

Gilles KERDREUX.

sourcePublié par Admin 00:13 0 commentaires

Nom de domaine en .eu

Les 10.000 premiers noms de domaine enregistrés bénéficieront de cette gratuité.

Ce vendredi 30 mai, nous allons proposer le .EU gratuit pendant quelques heures à partir d'environ midi jusqu'à ce que 10000 .eu soient commandés

Nous allons enregistrer les commandes demain et la réalisation de commandes commencera le 1 juin à minuit (le dimanche)

Le renouvellement du nom de domaine n'est pas obligatoire. Si vous trouvez de l'intérêt à renouveler votre .EU dans 1an il ne vous coûtera que 5.99Euro HT/an.

OVH avait déjà fait une même opération pour les .fr il y a quelques temps, elle avait rencontré un franc succès.

Publié par Admin 04:00 0 commentaires

Libellés : hebergeur, nom de domaine, ovh

Comment apparaitre dans Google News

Il faut s’assurer de la visibilité des actualités pendant au moins 30 jours avant qu’elles soient archivées. C'est la durée pendant laquelle Google News indexe les articles. Si le robot ne peut plus accéder à une page qu'il avait préalablement indexée, elle ne sera pas non plus disponible sur Google News.

Il faut contacter Google par mail à cette adresse source-suggestions-fr@google

Pour inscrire la rubrique actualité à Yahoo News, il faut remplir ce questionnaire :

http://help.yahoo.com/l/fr

Yahoo est plus lent que Google à accepter des nouveaux sites, donc pas d’inquiétude si vous n’avez pas de réponse rapidement.

Publié par Admin 03:43 0 commentaires

Libellés : google news

Trier les résultats Google par date

Par défaut, Google affiche les pages triées par pertinence sans se soucier de leur date de publication. Il est toutefois possible de limiter les résultats en fonction de leur date de publication. Pour cela, il vous suffit de rajouter cette extension à votre URL de résultat :

&as_qdr=d

Dans ce cas, vous aurez la possibilité de filtrer vos résultats en fonction de leur date de parution. Selon votre choix, seules les pages publiées depuis 24 heures, une semaine, un mois et jusqu'à un an seront pris en compte. Ils seront classés par ordre de pertinence. Vous pouvez également choisir d'ajouter ce lien en marque-pages :

javascript:window.location+="&as_qdr=d";

Il vous suffira de cliquer sur ce raccourci lorsque vous naviguerez sur un résultat de recherche pour voir la liste défilante apparaître.

Cette petite astuce peut se révéler très pratique dans de multiples cas : pour rechercher une actualité, pour limiter votre veille à une période précise, pour obtenir régulièrement de nouveaux résultats de recherche sur une requêtes bien précise...

Publié par Admin 05:25 3 commentaires

Les back links

Les liens naturels sont l'essence originelle du web et la base de l'algorithme du PageRank de Google et des autres moteurs. Si le contenu du site A interesse le webmaster du site B, celui-ci n'hésitera pas à faire un lien vers la page de contenu. L'idée des moteurs était alors de se dire que plus une page récoltait de liens naturels, plus cette page était interressante et méritait d'être proposée dans les premiers résultats aux internautes. On notera que le lien naturel peut être assimilé à une recommandation : "le webmaster du site B recommande la page du site A en lui faisant un lien naturel".

Pour les webmasters, quel plaisir de découvrir qu'un site vous a recommandé car ça signifie que tout votre dur labeur a payé. Le marketeur, lui, sera ravi du ciblage et de la qualité d'un lien récolté sans le moindre effort, lien générateur de trafic ciblé et de positionnement dans les outils de recherche.

La plupart des webmasters récoltent des liens naturels sur des sites de types blog perso, forum, sites persos, ...

Et ne croyons pas que cette période est révolue, ça arrive encore et heureusement !

Par contre, on notera que récolter des liens naturels entre aussi dans une démarche marketing et on peut le regretter : Comment récolter des liens naturels si on n'est pas déjà visible ? C'est un peu le chat qui se mord la queue : si je ne suis pas visible, je ne suis pas connu et je ne récolte pas de liens naturels donc je ne suis pas visible et personne ne me connait. Les techniques SEO, achat de liens générateurs de trafic, buzz marketing permettent de se créer des liens naturels assez rapidement (et même de manière virale). Récolter des liens naturels n'est donc pas si naturel que ça. C'est un métier de savoir le provoquer, de faire parler de vous.

On notera tout de même que la meilleur manière de récolter ce type de liens reste de publier un contenu de qualité.

2- Les liens SEO

Les marketeurs ont vite compris l'intérêt d'avoir des liens dans une démarche de visibilité et de conversion. Quel intérêt à se tuer à développer un site si personne ne le consulte ?

On distinguera 2 objectifs principaux :

- Favoriser et accélérer la phase d'indexation des pages

- Positionner chaque page indexée

On sera tous d'accord que si ces 2 objectifs sont remplis, les moteurs nous amèneront une mane de visiteurs très conséquente !!!

2.1. Favoriser et accélérer la phase d'indexation des pages du site

L'image assez simpliste d'imaginer le web comme une toile d'araignée peut permettre de comprendre ce phénomène. Si un robot d'indexation parcourait le web de manière aléatoire sur chaque fil de la toile, il aurait beaucoup plus de chance de tomber sur votre site si beaucoup de fils pointent vers vos pages.

Là encore, on distinguera 2 niveaux :

- Favoriser le crawl et la mise à jour de l'indexation des pages

- Accélérer le crawl des nouvelles pages

De nombreux outils et techniques permettent de récolter des liens :

- Les annuaires restent le moyen le plus simple mais peut-être aussi le moins efficace à cause d'un trop grand nombre de liens sortants. On préferera se concentrer sur des annuaires de qualité dont je ne vais pas refaire la liste des critères (lien en dur, beaucoup de lien entrants, annuaire thématique, pas de liens de retour, notoriété, ...). Cependant, les liens dans les annuaires restent un 1er outil efficace pour avoir plus de poids face à une négociation pour un échange de lien avec des sites partenaires.

- Les échanges de liens sont le meilleur moyen de favoriser l'indexation des pages. Plusieurs formes à prendre en compte : 1 contre 1, x contre x, A -> B / B -> A, A -> B / B -> C, etc... On notera aussi que le choix des partenaires et du mode de partenariat doit répondre à un objectif précis pour améliorer l'indexation : Quels sont les noeuds et points stratégiques en matière d'indexation pour mon site ? Si vous savez répondre à cette question, vous savez vers quelle page de votre site le lien partenaire doit pointer (on notera généralement la home ou le plan de site mais les réponses sont spécifiques à chaque architecture de site).

- Ce que j'appelle les "liens liquides" sont des liens à durée de vie très courte comme par exemple les liens générés par les flux RSS. Leur gros avantage est de pointer les pages les plus à jour d'un site (dernières actualités, derniers message du forum, dernier billet du blog, ...). Ce type de lien permet évidemment d'accéler l'indexation de vos pages et pourquoi pas de gagner une longueur d'avance sur vos concurrents.

- etc... Toute forme d'acquisition de liens

2.2. Positionner chaque page indexée

Surement le point qui vous interessera le plus car c'est le travail qu'on demande à un SEO : "être 1er sur un maximum de requêtes ciblées de manière à créer de la visibilité et du traffic via les moteurs de recherche".

Avant toute chose, il faut savoir ce qu'est un lien qui va vous faire gagner en positionnement. Voici une rapide analyse personnelle, vous trouverez tout un tas d'information sur le forum à ce sujet (qui n'est pas forcément le sujet de ce dossier au départ).

Ce qu'on sait sur le positionnement et les liens :

- L'ancienneté d'une page entre en jeu lors du positionnement, l'accélération de son indexation dans un contexte concurrentiel entre donc en jeu.

- un lien du type Pouic améliore le positionnement de la page "page.htm" sur le terme "Pouic" et améliore plus généralement la popularité du siteA

- Les moteurs analysent le nuage de liens autour d'un site (liens entrants et sortants) pour calculer ce qu'on appelle le TrustRank ou indice de confiance du site siteA.

On sait que les moteurs luttent contre les techniques des SEO (car elles perturbent le classement des réponses) en filtrant les liens artificiels. L'objectif du SEO sera de faire des liens de manière à ce qu'ils ressemblent le plus possible à un lien naturel.

Comment ?

- un lien naturel ne pointe généralement pas vers la home d'un site mais vers une page de contenu spécifique

- un lien naturel se trouve généralement à l'intérieur d'un texte et pas au milieu d'une liste de lien

- la page qui fait un lien naturel n'a généralement pas une quantité exorbitante de liens sortants

- le site qui fait un lien naturel est généralement dans la même thématique que le site lié (ou du moins, il y a un intérêt éditorial à faire ce type de lien)

- etc...

Quels outils ?

- Les annuaires de qualité. J'en ais déjà parlé plus haut, leur qualité en terme de positionnement n'est pas non plus extraordinaire à cause de leur trop grand nombre de liens sortants, d'un ciblage de thématique de mauvaise qualité, ...

- Les échanges de liens sont un moyen très efficace d'améliorer le positionnement si on respecte les règles énoncées ci-dessus (assurez-vous que vos liens ressemblent à des liens naturels). Contrairement, à l'échange de lien visant à améliorer l'indexation des pages, ce type d'échanges de lien permet de vous positionner sur des requêtes génératrice de trafic. Les pages à lier ne sont donc pas forcément les mêmes. Quels sont mes pages susceptibles de récolter le plus de trafic qualifié ? Si vous savez répondre à cette question, vous savez vers quelle page de votre site le lien partenaire doit pointer.

- etc... Toute forme d'acquisition de liens

3- Les liens générateurs de traffic (et de conversion)

3.1. Provoquer le buzz marketing et le viral

J'en parlais dans le 1er point, le marketeur peut provoquer la création de liens naturels. Il convient d'identifier les sites faisant autorité dans votre domaine et d'avoir suffisament d'imagination et de compétences en communication pour diffuser une information qui sera reprise et relayée sur des blogs, forums, ... Les techniques sont multiples et spécifiques à chaque cas, c'est pour ça que je n'en parlerais pas ici.

3.2. Achat de liens stratégiques et qualifiés

Ce type de liens est plus utilisé par les sites commerciaux, conscient que la convertion de leur visites en chiffre d'affaire doit passé par une maitrise de leur trafic. On notera toutes les techniques de liens sponsorisés, publicité, publi-reportage, ... Le webmaster du site A paye généralement une prestation pour avoir une place stratégique dans le contenu du site B, site B ayant au préalable fait l'étude d'une analyse (cible, prévision de convertion, analyse rapport qualité/prix, étude du retour sur investissement, ...)

Publié par Admin 02:25 0 commentaires

SEO Quiz

J'ai eu un score assez faible à mon gout, mais je peux mettre ça sur le compte de mon faible niveau en anglais...

SEO Novice - 51%

Your Results

-

#1 Which of the following is the least important area in which to include your keyword(s)?

Your Answer: Meta Keywords

Correct Answer: Meta Keywords

The meta keywords tag is least important among these because search engines do not consider it in ranking calculations and it's never seen by visitors or searchers (unlike the meta description tag, which displays beneath listings in the SERPs).

-

#2 Which of the following would be the best choice of URL structure (for both search engines and humans)?

Your Answer: www.wildlifeonline.com/animals/crocodile

Correct Answer: www.wildlifeonline.com/animals/crocodile

The best choice would be www.wildlifeonline.com/animals/crocodile - it provides the most semantic information, the best description of the content on the page and contains no parameters or subdomains that could cause issues at the engines. For more on URL structuring, see this post on SEOmoz.

-

#3 When linking to external websites, a good strategy to move up in the rankings is to use the keywords you're attempting to rank for on that page as the anchor text of the external-pointing links. For example, if you were attempting to rank a page for the phrase "hulk smash" you would want to use that phrase, "hulk smash" as the anchor text of a link pointing to a web page on another domain.

Your Answer: False

Correct Answer: False

The biggest problem with linking out to other websites with your targeted keyword phrases in the anchor text is that it creates additional competition for your page in the search results, as you give relevance through anchor text and link juice to a competing page on a competing site. Thus, FALSE is the correct answer.

-

#4 Which of the following is the best way to maximize the frequency with which your site/page is crawled by the search engines?

Your Answer: Frequently add new content

Correct Answer: Frequently add new content

Adding new content on a regular basis is the only one of the methods listed that will promote more frequent spidering and indexing. Tags like crawl delay have never been shown to be effective (and aren't even supported by many of the major engines). The other "partially" correct answer would be to turn up crawl frequency inside Webmaster Central at Google, but this only works if Google wants to crawl your site more actively and is restricted from doing so.

-

#5 Which of the following is a legitimate technique to improve rankings & traffic from search engines?

Your Answer: Re-writing title tags on your pages to reflect high search volume, relevant keywords

Correct Answer: Re-writing title tags on your pages to reflect high search volume, relevant keywords

Of the choices, only the option to change title tags to reflect better keywords is a legitimate and effective SEO technique.

-

#6 Danny Sullivan is best known (in the field of web search) as:

Your Answer: A journalist and pundit who covers the field of web search

Correct Answer: A journalist and pundit who covers the field of web search

Although there's an answer we'd love to choose :), the correct answer is that Danny's a journalist and pundit on web search who currently operates the SearchEngineLand blog and runs the SearchMarketingExpo event series.

-

#7 Which of the following is the WORST criterion for estimating the value of a link to your page/site?

Your Answer: The PageRank of the page in the Google toolbar

Correct Answer: The popularity of the domain on which the page is hosted according to Alexa

Since Alexa data is typically less useful than monkey's throwing darts at a laptop, that's the obvious choice for worst metric. The others can all contribute at least some valuable insight into the value a link might pass.

-

#8 How can Meta Description tags help with the practice of search engine optimization?

Your Answer: They serve as the copy that will entice searchers to click on your listing

Correct Answer: They serve as the copy that will entice searchers to click on your listing

The correct answer is that they serve as the copy in the SERPs and are thus valuable for influencing click-through rates.

-

#9 Which of the following content types is most easily crawled by the major web search engines (Google, Yahoo!, MSN/Live & Ask.com)?

Your Answer: XHTML

Correct Answer: XHTML

XHTML is the obvious choice as the other file types all create problems for search engine spiders.

-

#10 Which of the following sources is considered to be the best for acquiring competitive link data?

Your Answer: Google

Correct Answer: Yahoo!

Since Yahoo! is the only engine still providing in-depth, comprehensive link data for both sites and pages, it's the obvious choice. Link commands have been disabled at MSN, throttled at Google, never existed at Ask.com and provide only a tiny subset of data at Alexa.

-

#11 Which of the following site architecture issues MOST impedes the ability of search engine spiders to crawl a site?

Your Answer: Pages that require form submission to reach database content

Correct Answer: Pages that require form submission to reach database content

Since search engines will assume a site is crawlable if it has no robots.txt file, doesn't have any crawl-specific issues with paid links, can read iFrames perfectly well and is able to spider and index plenty of pages with multiple URL parameters, the correct answer is clear. Pages that require form submission effectively block spiders, as automated bots will not complete form submissions to attempt to discover web content.

-

#12 What is the generally accepted difference between SEO and SEM?

Your Answer: SEO focuses on organic/natural search rankings, SEM encompasses all aspects of search marketing

Correct Answer: SEO focuses on organic/natural search rankings, SEM encompasses all aspects of search marketing

SEO - Search Engine Optimization - refers to the practice of ranking pages in the organic results at the search engines. SEM - Search Engine Marketing - refers to all practices that leverage search engines for traffic, branding, advertising & marketing.

-

#13 Which of these is NOT generally considered to be a highly important factor for ranking for a particular search term?

Your Answer: HTML Validation (according to W3C standards) of a page

Correct Answer: HTML Validation (according to W3C standards) of a page

As this document would indicate, W3C validation is clearly the odd man out in this bunch.

-

#14 When creating a "flat architecture" for a site, you attempt to minimize what?

Your Answer: The number of links a search engine must follow to reach content pages

Correct Answer: The number of links a search engine must follow to reach content pages

Flat site architecture refers to the link structure of the site, and thus, the only answer is "the number of links a search engine must follow to reach content pages."

-

#15 In the search marketing industry, what is traditionally represented by this graph?

Your Answer: The "long tail" theory of keyword demand

Correct Answer: The "long tail" theory of keyword demand

The graph shown represents the long tail concept, which is most frequently applied to keyword demand in the search marketing world. The theory is explained in detail here.

-

#16 Which of the following is NOT a "best practice" for creating high quality title tags?

Your Answer: Limit the tag to ~65 characters, including spaces

Correct Answer: Include an exhaustive list of keywords

Since all the rest are very good ideas for title tag optimization (see this post for more), the outlier is to include an exhaustive list of keywords. Title tags are meant to describe the content on the page and to target 1-2 keyword phrases in the search engines, and thus, it would be terribly unwise to stuff many terms/phrases into the tag.

-

#17 Which of the following character limits is the best choice to use when limiting the length of title tags (assuming you want those tags to fully display in the search results at the major engines)?

Your Answer: 110

Correct Answer: 65

As Google & Yahoo! both display between 62-68 characters (there appears to be some various depending on both the country of origin of the search and the exact query), and MSN/Live hovers between 65-69, the best answer is... 65!

-

#18 PageRank is so named because it was created by Larry Page, not because it ranks pages.

Your Answer: TRUE

Correct Answer: TRUE

As you can read on Google's fun facts page, PageRank was named for its co-creator, Larry.

-

#19 A page on your site that serves as a "sitemap," linking to other pages on your domain in an organized, list format, is important because...

Your Answer: It may help search engine crawlers to easily access many pages on your site

Correct Answer: It may help search engine crawlers to easily access many pages on your site

As none of the others are remotely true, the only correct answer is that a sitemap page may help search engine crawlers easily access many pages on your site, particularly if your link structure is otherwise problematic.

-

#20 Which of the following search engines patented the concept of "TrustRank" as a methodology for ranking web sites & pages?

Your Answer: Google

Correct Answer: Yahoo!

The correct answer comes via the patent guru himself, Bill Slawski, who notes:

The citation that I’ve seen most commonly pointed at regarding trustrank is this paper - Combating Web Spam with TrustRank (pdf).

The authors listed on that paper are the named inventors on this Yahoo patent application:

1 Link-based spam detection (20060095416)

The remaining four describe an expansion of the trustrank process, referred to as dual trustrank, which adds elements of the social graph to the use of trustrank.

2 Using community annotations as anchortext (20060294085)

3 Realtime indexing and search in large, rapidly changing document collections (20060294086)

4 Trust propagation through both explicit and implicit social networks (20060294134)

5 Search engine with augmented relevance ranking by community participation (20070112761)

-

#21 Why are absolute (http://www.mysite.com/my-category)URLs better than relative ("/my-category") URLs for on-page internal linking?

Your Answer:

Correct Answer: When scraped and copied on other domains, they provide a link back to the website

None of the answers makes sense, except that which refers to scrapers, who often copy pages without changing links and will thus link back to your site, helping to reduce duplicate content issues, and potentially provide some link value as well.

-

#22 How can you avoid the duplicate content problems that often accompany temporal pagination issues (where content moves down a page and from page to page, as is often seen in lists of articles, multi-page articles and blogs)?

Your Answer: Link to paginated pages with rel="nofollow" in the link tag

Correct Answer: Add a meta robots tag with "noindex, follow" to the paginated pages

The only method listed in the answers that's effective is to use "noindex, follow" on the paginated, non-canonical pages.

-

#23 If you update your site's URL structure to create new versions of your pages, what should you do with the old URLs?

Your Answer: 301 redirect them to the new URLs

Correct Answer: 301 redirect them to the new URLs

The correct move is to 301 the pages so they pass link juice and visitors to the new, proper locations.

-

#24 When you have multiple-pages targeting the same keywords on a domain, which of the following is the best way to avoid keyword cannibalization?

Your Answer: Place links on all the secondary pages back to the page you most want ranking for the term/phrase using the primary keywords as the anchor text of those links

Correct Answer: Place links on all the secondary pages back to the page you most want ranking for the term/phrase using the primary keywords as the anchor text of those links

As this blog post explains, it's best to "place links on all the secondary pages back to the page you most want ranking for the term/phrase using the primary keywords as the anchor text of those links."

-

#25 The de-facto version of a page located on the primary URL you want associated with the content is known as:

Your Answer: Empirical Version

Correct Answer: Canonical Version

The only answer that is generally accepted in the search community is "canonical version."

-

#26 Which domain extensions are more often associated with greater trust and authority in the search engines?

Your Answer: .com and .net

Correct Answer: .edu, .mil and .gov

Although the search engines themselves have said there are no specific algorithmic elements that make domains from .gov, .edu and .mil more trustworthy or authoritative, these sites, due to the restriction of the TLD licensing, certainly have an association with more trust in webmaster's eyes (and, very often, the search results).

-

#27 High quality links to a site's homepage will help to increase the ranking ability of deeper pages on the same domain.

Your Answer: TRUE

Correct Answer: TRUE

The answer is "TRUE" as the properties of PageRank, domain trust, authority and many other search ranking factors will cause internal pages on a well-linked-to domain to rank more highly.

-

#28 The practice of showing one version of content on a URL to search engines, and another, different version to human visitors of the same URL is known as?

Your Answer: Cloaking

Correct Answer: Cloaking

As WebmasterWorld notes, this practice is called cloaking.

-

#29 Which HTTP server response code indicates a file/folder that no longer exists?

Your Answer: 404

Correct Answer: 404

The W3C standards for HTTP status codes tells us that 404 is the correct answer.

-

#30 Spammy sites or blogs begin linking to your site. What effect is this likely to have on your search engine rankings?

Your Answer: It may negatively affect your rankings as search engines associate your site with bad neighborhoods on the web

Correct Answer: A very slight positive effect is most likely, as search engines are not perfectly able to discount the link value of all spammy sites

The correct answer is that a very slight positive effect is most likely. This is because search engines do NOT want to penalize for the acquisition of spammy links, as this would simply encourage sites to point low quality links at their competition in order to knock them out of the results. The slight positive effect is typical because not all engines are 100% perfect at removing the link value from spam.

-

#31 A link from a PageRank "3" page (according to the Google toolbar) hosted on a very strong, trusted domain can be more valuable than a link from a PageRank "4" page hosted on a weaker domain.

Your Answer: TRUE

Correct Answer: TRUE

Since PageRank is not nearly the overwhelmingly strong factor influencing search rankings at Google these days, the answer is definitely "TRUE."

-

#32 What's the largest page size that Google's spider will crawl?

Your Answer: 250K

Correct Answer: No set limit exists - Google may crawl very large pages if it believes them to be worthwhile

As evidenced by many of the 500-100K+ pages in Google's index, there is no set limit, and the search engine may spider unusually large documents if it feels the effort is warranted (particularly if many important links point to a page).

-

#33 Is it generally considered acceptable to have the same content resolve on both www and non-www URLs of a website?

Your Answer: No, this may cause negative indexing/ranking issues

Correct Answer: No, this may cause negative indexing/ranking issues

This is generally considered a bad idea, and may have negative effects if the search engines do not properly count links to both versions (the most common issue) or even view the two as duplicate, competing content (unlikely, though possible).

-

#34 Which HTTP server response code indicates a page that has been temporarily relocated and links to the old location will not pass influence to the new location?

Your Answer: 302

Correct Answer: 302

The W3C standards for HTTP status codes tells us that 302 is the correct answer.

-

#35 Which of these is least likely to have difficulty ranking for its targeted terms/phrases in Google?

Your Answer: A new domain that has received significant buzz and attention in the online and offline media, along with tens of thousands of natural links

Correct Answer: A new domain that has received significant buzz and attention in the online and offline media, along with tens of thousands of natural links

This is a tough question, and the answer is even somewhat debatable. However, as phrased, the MOST correct answer is almost certainly - "A new domain that has received significant buzz and attention in the online and offline media, along with tens of thousands of natural links" - as each of the other situations have many examples of having very difficult times ranking well.

-

#36 What is the advantage of putting all of your important keywords in the Meta Keywords tag?

Your Answer: There is no specific advantage for search engines

Correct Answer: There is no specific advantage for search engines

The answer is that no advantage is conferred upon sites who include their terms in the meta keywords tag. For more on the subject, read Danny Sullivan's excellent post.

-

#37 Which of the following link building tactics do search engines tacitly endorse?

Your Answer: Reciprocal link exchange programs

Correct Answer: Viral content creation & promotion

As representatives from each of the major engines have acknowledged publicly, viral content creation and promotion is viewed as a legitimate and preferred tactic for link acquisition.

-

#38 Which HTTP server response code indicates a page that has been permanently relocated and all links to the old page will pass their influence to the new page location?

Your Answer: 301

Correct Answer: 301

The W3C standards for HTTP status codes tells us that 301 is the correct answer.

-

#39 Which of the following factors is considered when search engines assign value to links?

Your Answer: The use of a proper link title in the HTML tag of the link, matching the anchor text of the link

Correct Answer: The date/time the link was created and the temporal relationship between that link's appearance and other time-sensitive criteria

The only one of these that search engines would consider (and have mentioned in patent applications like this one) is the temporal data.

-

#40 There is no apparent search engine rankings benefit to having a keyword-matched domain name (eg www.example.com for keyword "example").

Your Answer: FALSE

Correct Answer: FALSE

This is "FALSE," as many examples of keyword-targeted domains have been shown to have a phenomenal amount of ranking success in the engines, despite other factors not being nearly as strong as the competition.

-

#41 If you want a page to pass value through its links, but stay out of the search engines' indices, which of the following tags should you place in the header?

Your Answer: Use meta robots="noindex, nofollow"

Correct Answer: Use meta robots="noindex, follow"

As Google tells us here, the proper format would be to use meta robots="noindex, follow"

-

#42 Which of these factors is LEAST likely to decrease the value of a link?

Your Answer: The linked-to and linking sites are both hosted on the same IP address

Correct Answer: The linked-to domain has a link somewhere that points at the linking domain (each domain link to pages on the other's site)

The right answer is "a link from the domain being linked to pointing at the linking site already exists (each domain link to pages on the other's site)." This is because despite the fact that these links are technically "reciprocal," they don't fit any pattern of penalization for such links (such as being listed on link list style pages). The search engines are least likely to devalue these because of all the natural patterns in which such linking occurs (blogrolls, news sites, forums, hobbyists, schools, etc.)

-

#43 Which of the following is a requirement for getting in the Google Local listings?

Your Answer: Registering the site with Google's Webmaster Tools program

Correct Answer: A physical mail address in your claimed location

The only one that's a must-have is the physical mailing address.

-

#44 Which of the following engines offers paid inclusion services for their main web index (not advertising):

Your Answer: Google

Correct Answer: Yahoo!

Currently, only Yahoo! offers paid inclusion through their search submit program.

-

#45 When is it advisable to leave the meta description off of a page?

Your Answer: When you don't want people to know what the page is about

Correct Answer: When a large amount of pages exist and the options are between using a single meta description for all of the pages vs. leaving them with none at all

The correct answer is "When a large amount of pages exist and the options are between using a single meta description for all of the pages vs. leaving them with none at all." Duplicate meta description tags aren't the worst thing in the world, but they're certainly not providing any value and may have downsides from a duplicate content perspective (particularly if page content is very similar). Besides that, the other answers simply don't make sense :)

-

#46 A domain will not be hurt by having a penalized site or page 301'd to it.

Your Answer: FALSE

Correct Answer: TRUE

This is "TRUE," and has been tested by many a black hat. The danger here is that, once again, crafty spammers could use this technique to hurt their competitors if the search engines did penalize the receiving domain.

-

#47 Which of the following strategies is the best way to lift a page out of Google's supplemental index?

Your Answer: Link to it internally from strong pages

Correct Answer: Link to it internally from strong pages

As "supplemental" has been defined by engineers at Google as being a page with very little PageRank, the best way to lift it out, from the options given, is to link to it internally from strong pages.

-

#48 Which of the following is NOT speculated to be a contributing factor in achieving "breakout" site results in Google?

Your Answer: Having multiple popular pages on your site

Correct Answer: Having an active AdWords campaign

The only one that doesn't fit is the use of an AdWords campaign, which Google has said has no impact on organic listings.

-

#49 Which of the following is the best method to insure that a page does not get crawled or indexed by a search engine?

Your Answer: Restrict the page using robots.txt

Correct Answer: Restrict the page using robots.txt

The clear best method above, and the one prescribed by the engines, is to use the robots.txt file to restrict access.

-

#50 If you want to rank for a country specific TLD/Top-Level-Domain extension (such as Yahoo.jp or Google.ca) which of the following is NOT important?

Your Answer: Linking out only to other sites with the targeted TLD extension

Correct Answer: Linking out only to other sites with the targeted TLD extension

Linking out only to other sites with the targeted TLD extension is certainly not a requirement nor a suggested method for inclusion into a country-specific search engine's results. See this recent video for more.

-

#51 Which of the following CANNOT get you penalized at the major search engines?

Your Answer: Using "nofollow" internally on your site to control the flow of link juice

Correct Answer: Using "nofollow" internally on your site to control the flow of link juice

As Matt Cutts has noted recently, using "nofollow" to sculpt the flow of link juice is perfectly acceptable.

-

#52 Which of the following directories had its ability to pass link value removed?

Your Answer: www.dmoz.org - The Open Directory Project

Correct Answer: www.bluefind.org - The Bluefind Web Directory

Only BlueFind suffered this penalty - having had its ability to pass link value removed by Google, ostensibly for "selling PageRank."

-

#53 Which of the following is an acceptable way to show HTML text to search engines while creating a graphical image to display to users?

Your Answer: CSS layers - show the text on a layer underneath the image atop

Correct Answer: CSS image replacement - create a rule in the CSS file that replaces the text with an image based on a given class

The only method that's approved by search engines is to use CSS image replacement with the exact copy in both the image and the HTML text.

-

#54 For high-volume search phrases, the Search Engines usually will not differentiate between singular and plural versions of a term (eg "cell phone" vs. "cell phones" or "bird feeder" vs. "bird feeders").

Your Answer: FALSE

Correct Answer: FALSE

As we can see from searches on the various phrases - cell phone vs. cell phones and bird feeder vs. bird feeders - this is FALSE. There are clear differentiations.

-

#55 If your site is ranked in the #1 organic position for a given query, advertising in the top paid position for that search result will generally not produce an additional volume of search traffic.

Your Answer: FALSE

Correct Answer: FALSE

Research from several sources, including this eye-tracking research report from MarketingSherpa, indicates that the correct answer is FALSE. You get more traffic and click-throughs with both the top paid and organic results than either individually.

-

#56 What's likely to happen if multiple accounts on a single IP address vote up a story at Digg in a short time period?

Your Answer: Nothing special, just more Diggs

Correct Answer: Your accounts will be suspended

The most likely result, particularly if this is done multiple times, is to have the accounts suspended.

-

#57 Let's assume that you're running SEO for an auction website with many listings, sorted by categories and subcategories. To achieve the maximum search engine traffic benefit, what should you do with individual product/auction pages after the auction has expired and the product is no longer available?

Your Answer: 301 redirect the pages to the home page to keep any external link juice flowing through the site

Correct Answer: 301 redirect them to the most appropriate category page associated with the product

The "best" answer of the choices given is to 301 redirect the pages to the most appropriate category page associated with the product - this ensures that link value won't be lost, and visitors who come to the old page will get the best user experience as well.

-

#58 Which factor is most likely to decrease the ranking value of a link?

Your Answer: Uses "click here" as the anchor text

Correct Answer: Comes from a page with many reciprocal and paid links

All of the answers can provide significant link value except "comes from a page with many reciprocal and paid links," which is very likely to have a strong negative affect on the value of the link.

-

#59 Which of the following search engine and country combination does not represent the most popular search engine in that country?

Your Answer: Russia / Yandex

Correct Answer: Japan / Yahoo

All of the above are correct, except Japan, where Google appears to now have a dominant search market share, despite Yahoo! getting more web traffic and visits. See also this piece from Multilingual-Search.com.

-

#60 Where do search engines consider content inside an iFrame to be located?

Your Answer: Search engines cannot spider content in iFrames

Correct Answer: On the source page the iFrame pulls from

Engines judge iframe content the same way browsers do, and consider them to be part of the source page the iFrame pulls from (not the URL displaying the iFrame content).

-

#61 If the company you buy links from gets "busted" (discovered and penalized) by a search engine, the links you have from them will:

Your Answer: Cause your site to be penalized

Correct Answer: Stop passing link value

Since search engines don't want to give webmasters the ability to knock their competitors out with paid links, they will simply devalue the links they discover to be part of paid networks, such that they no longer pass value.

-

#62 Which of these queries would not have an "Instant Answer" or "Onebox Result" on Google?

Your Answer: Salsa Recipes

Correct Answer: Best Chinese Restaurant in San Francisco

No surprisingly, the only correct answer is "Best Chinese Restaurant in San Francisco."

-

#63 Which major search engine serves advertising listings (paid search results) from the PPC program of one of the other major engines?

Your Answer: Google

Correct Answer: Ask.com

Ask.com is the only major engine that shows ad results from another engine - specifically, Google.

-

#64 Duplicate content is primarily an off-site issue, created through content licensing deals and copyright violations of scraped and re-published content, rather than a site-internal problem.

Your Answer: FALSE

Correct Answer: FALSE

The answer is FALSE, as on-site duplicate content issues can be serious and cause plenty of problems in the search engines.

-

#65 Links from 'noindex, follow' pages are treated exactly the same as links from default ('index, follow') pages.

Your Answer: FALSE

Correct Answer: TRUE

This is TRUE - according to Matt Cutts in a comment here, links on pages with "noindex, follow" are treated exactly the same as links from default ("index, follow") pages.

-

#66 Which metric is NOT used by the major search engines to measure relevance or popularity in their ranking algorithms?

Your Answer: Keyword density in text on the page

Correct Answer: Keyword density in text on the page

Keyword density is the outlier here. Dr. Garcia explains why search engines don't use the metric here.

-

#67 If they have the same content, the Search Engines will consider example.com/avocado and example.com/avocado/ to be the same page.

Your Answer: TRUE

Correct Answer: TRUE

The answer is TRUE, as engines don't consider the trailing slash to create a different page (examples here and here).

-

#68 Which Search Engines currently allow the 'nocontent' attribute?

Your Answer: Yahoo!

Correct Answer: Yahoo!

To date, only Yahoo! has implemented the nocontent parameter.

-

#69 In which of the following countries does Ask.com have the most significant percentage of search engine market share?

Your Answer:

Correct Answer: United States

Surprisingly, the answer is the US, where Ask.com has an estimated 5% market share.

-

#70 For search engine rankings & traffic in Google & Yahoo!, it is generally better to have many, small, single topic focused sites with links spread out between them than one, large, inclusive site with all the links pointing to that single domain.

Your Answer: FALSE

Correct Answer: FALSE

This is FALSE, primarily because the search engines' current algorithms places a great deal of weight on large, trusted domains, rather than small, niche sites.

-

#71 The 4 major search engines - Google, Yahoo!, MSN/Live and Ask serve what approximate percentage of all searches performed in the US?

Your Answer: ~50%

Correct Answer: ~95%

According to nearly every study reported (including ComScore's), the four major networks, when AOL is included (serving Google results), provide ~95% of all searches in the US.

-

#72 The linkfromdomain operator displays what information and is available at which search engine(s)?

Your Answer: Data on who is linking to a given website - available at MSN/Live only

Correct Answer: Data on what websites are linked-to from a given domain - available at MSN/Live only

As can be seen here, Microsoft/Live is the only engine to provide the command and it shows what pages are linked-to by a given domain.

-

#73 Which of the following social media websites is the least popular (as measured by active users & visitors)?

Your Answer: Newsvine

Correct Answer: Newsvine

Newsvine is the smallest of the above, both in terms of traffic and users.

-

#74 Which of the following pieces of information is NOT available from current keyword research sources?

Your Answer: Cost per click paid by PPC advertisers

Correct Answer: Cost per click paid by PPC advertisers

Since all of the current search engines have blind bid systems, the cost-per-click paid by advertisers is currently unavailable anywhere.

-

#75 The use of AJAX presents what common problem for search engines and websites?

Your Answer: Search engines will not index pages with Javascript on them

Correct Answer: It creates multiple pages with unique content without enabling new, spiderable, linkable URLs

The largest problem for search engines is that AJAX frequently "creates multiple pages with unique content without enabling new, spiderable, linkable URLs."

Publié par Admin 09:02 0 commentaires